Nell’ultimo periodo si stanno verificando eventi atmosferici piuttosto violenti per i quali si è invocato spesso il ruolo del riscaldamento globale. Ma cosa sappiamo di preciso? Si possono attribuire singoli eventi particolarmente violenti all’innalzamento delle temperature? Come funzionano i modelli che studiano possibili attribuzioni e previsioni? Ne abbiamo parlato con la statistica Claudia Tebaldi, che è anche autrice principale per il rapporto IPCC appena uscito.

Immagine: Pexels.

È uscito ieri il primo volume del sesto rapporto IPCC sui cambiamenti climatici che ha confermato quanto già noto sulle cause umane e sulle conseguenze preoccupanti del riscaldamento globale. Il rapporto, tra le altre cose, pone maggiore attenzione rispetto al passato agli aspetti climatici regionali, così da agevolare una pianificazione territoriale più robusta. Qual è quindi il ruolo dell’innalzamento della temperatura globale media sui vari eventi meteorologici locali, come piogge intense e forti ondate di calore?

Lo abbiamo chiesto a Claudia Tebaldi, statistica, scienziata al Joint Global Change Research Institute (PNNL) e collaboratrice di Climate Central, autrice principale per il dodicesimo capitolo, Climate change information for regional impact and for risk assessment, del sesto Assessment Report dell’IPCC. È stata autrice principale anche del quinto rapporto IPCC (del 2014) e in generale è coinvolta nella scrittura dei rapporti IPCC da vari anni.

Intervista a Claudia Tebaldi

In breve, di cosa si occupa e cosa ha scritto per l’ultimo rapporto IPCC?

Io sono una statistica, ho iniziato più di vent’anni fa ad analizzare i risultati dei modelli di cambiamento climatico, con una specializzazione rivolta a quello che accade alle scale locali e in particolare gli eventi estremi. Nel capitolo di quest’ultimo rapporto IPCC l’idea è stata quella di produrre informazione rilevante per persone che devono prendere decisioni a livello regionale, se non locale; in particolare ci siamo concentrati su metriche che hanno importanza per gli impatti non solo ecologici, ma anche sull’economia e sulla salute.

Oltre alla correlazione statistica tra innalzamento delle temperature e aumento del numero di ondate di calore all’anno (così come altri parametri), si possono individuare anche nessi causali veri e propri?

Da punto di vista statistico non c’è bisogno di spiegazioni più profonde: il riscaldamento globale causa un riscaldamento regionale e vediamo come questo produce eventi estremi mediamente più frequenti. Il nodo cruciale è quando si considerano singoli eventi: non basta considerare solo il riscaldamento, ma entrano in gioco anche altri fattori, come la circolazione atmosferica. Si sono verificate recentemente nell’America occidentale delle forti ondate di calore – si parlava di “duomo” di aria calda che si è si è stabilizzato sulla regione per giorni – che non possono essere spiegate solo con il riscaldamento, ma che hanno bisogno anche dell’effetto dinamico dell’atmosfera. Quindi la correlazione può non essere sufficiente a spiegare questi fenomeni singoli nella loro interezza. Un altro esempio sono state le alluvioni in Germania. Anche in quel caso c’erano delle componenti dinamiche legate alla circolazione complesse da studiare, ma è chiaro che quando il sistema è riscaldato c’è più vapore acqueo in atmosfera e, quindi, quando piove, piove di più e più intensamente.

Allora come si fa a dire che senza riscaldamento globale alcuni eventi non si sarebbero verificati?

Questa area di ricerca usa molto i modelli, integrandoli con osservazioni che spesso sono anche relativamente limitate nel tempo. Ecco quindi che serve mettere insieme più fonti di informazioni possibili per ottenere le distribuzioni delle varie grandezze prese in considerazione, come la temperatura o le precipitazioni. Abbiamo quindi a che fare sostanzialmente con valori medi e variabilità, per molte regioni del mondo. I valori della temperatura, a livello locale, assumono generalmente la forma della distribuzione normale (cioè a campana), le precipitazioni invece seguono distribuzioni diverse, un po’ più complesse.

Per alcuni eventi molto rari si riesce a dimostrare che senza il riscaldamento globale questi non si sarebbero potuti verificare, perché si sono discostati eccessivamente dalle distribuzioni di riferimento, basate su osservazioni passate in cui il riscaldamento globale non c’era. Da questo punto di vista, il discostarsi di questi eventi dai valori attesi è così netto che può essere considerato il vero nesso causale tra innalzamento delle temperature ed eventi meteo estremi.

Oltre al confronto con le distribuzioni di eventi passati, come si sfruttano invece le simulazioni con i modelli?

Si usano modelli che, per un certo tipo di esperimenti, si fanno funzionare senza cambiare la concentrazione di gas serra nell'atmosfera. Questi tipi di esperimenti si chiamano “natural”, nel senso che si guarda come il sistema si comporta senza il disturbo antropico. Poi si prende lo stesso modello e lo si fa funzionare con le concentrazioni di gas serra osservate – o stimate per il futuro. Paragonando le distribuzioni si vede quindi che determinati eventi che sono accaduti – o che si pensa accadranno – sono molto più coerenti con la distribuzione per così dire “antropica” che non con quella naturale.

In generale, quanto è possibile restringere il focus geografico e temporale per fare questo tipo di studi?

Quando usiamo questi modelli globali – che sono estremamente costosi da far funzionare – in genere la scala spaziale è di 100 chilometri in lungo e largo. Ci sono modelli anche più raffinati, che però sono molto più costosi. Per inciso, in queste celle di 100 chilometri per 100 chilometri, i valori della temperatura sono tendenzialmente omogenei (a parte variazioni molto locali dovute per esempio alla differenza tra città e campagna), mentre i valori relativi alle precipitazioni sono più variabili.

Sulla scala temporale, questi modelli hanno una risoluzione anche di tre o sei ore, però l'interpretazione di quello che esce dal modello è un po’ più complessa. Questi non sono infatti i modelli delle previsioni del meteo, per cui si deve comunque tenere un approccio statistico: ci danno un'idea dei trend, della variabilità delle distribuzioni e così via. Ogni modello genera moltissimi eventi locali giornalieri possibili, che però vanno considerati nella loro totalità per ottenere degli scenari affidabili, che in genere sono sulla scala dei decenni.

Quali sono i principali limiti per queste attribuzioni e previsioni?

Questi modelli hanno delle limitazioni intrinseche. Ne esistono una ventina al mondo e ognuno è stato sviluppato non proprio indipendentemente: all’inizio ne esistevano pochissimi e quindi ci si è basati sulla conoscenza prodotta da quelli sviluppati precedentemente. Questi modelli sono formati da milioni e milioni di linee di codice, quindi sono complessissimi. Per esempio: per fare un esperimento che esplora il XXI secolo soltanto con una singola traiettoria (una singola linea di grafico per una determinata variabile, ndr), un supercomputer può impiegare anche un mese o un mese e mezzo. Questo processo è quindi estremamente costoso.

Il fatto poi che si debba avere una certa risoluzione spaziale fa sì che questi modelli contengano delle approssimazioni obbligate, che a loro volta introducono degli errori. Gli scienziati stanno continuamente cercando di curare queste approssimazioni, ma è un lavoro piuttosto difficile. La cosa che ci salva è che modelli diversi hanno punti di forza diversi, per cui mettendo insieme modelli differenti si ottengono risultati decisamente più robusti.

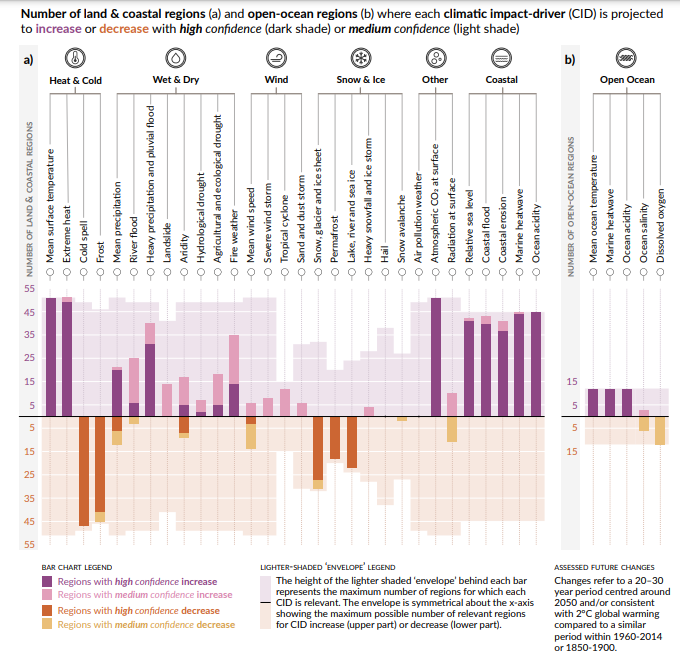

Variazioni regionali negli impact-driver climatici

Il capitolo del rapporto IPCC scritto da Claudia Tebaldi è stato in parte riassunto, assieme ad altri contenuti, nel Summary for Policymakers, da cui riportiamo il grafico che mostra in sintesi il numero di regioni in cui sono previste variazioni nei cosiddetti impact-driver climatici.