Intervenire su una crisi economica quale è quella che sta attraversando l’Europa in generale, e l’Italia in particolare, richiede un’analisi delle sue cause ben più complessa di quella che normalmente viene diffusa dai grandi mezzi d’informazione. Il termine di riferimento di tale crisi è – come ben noto – rappresentato dai valori dello “spread”, o in altre parole del differenziale (positivo) tra tassi di interesse sui titoli dei paesi “a rischio” e tassi dei titoli tedeschi - come “premio” per gli investitori per l’incertezza che grava sulla solidità delle economie più deboli - la cui crescente entità aumenta l’onere dei cosiddetti “debiti sovrani”. Comprendere quali siano le ragioni che inducono gli investitori a valutare la debolezza di una economia, diventa allora essenziale per poter poi concepire azioni efficaci per la riduzione dello “spread”, che consentano quindi di liberare risorse per riavviare il processo di crescita.

Le cronache correnti sono molto nette nell’indicare le cause dell’aumento dello “spread”. Esso stesso deriverebbe dall’onere dei “debiti sovrani”, i quali, sovraccaricati a loro volta dalla spesa per il pagamento di maggiori interessi, lo metterebbero ulteriormente sotto pressione, mantenendolo elevato o facendolo ancora aumentare, dando vita infine ad una sorta di circolo vizioso “debito-spread-debito”. Ma se è vero che l’onere da interessi contribuisce ad un peggioramento del quadro debitorio, è sbagliato imputare alle condizioni del debito pubblico, quali sono quelle che si son venute determinando nel corso della presente crisi, l’origine delle cattive condizioni in cui versano le economie in cui lo “spread” è particolarmente elevato. Capire perché questo è sbagliato è molto importante non solo per ricostruire un quadro della crisi in cui si dia conto del reale svolgimento dei processi che hanno scatenato la sofferenza finanziaria dei “debiti sovrani”, ma anche, e soprattutto, affinché le politiche da attuare per “allentare” la pressione sullo spread, siano efficaci e non controproducenti.

Le politiche dell’ “austerità” – il cui obiettivo consiste nell’abbattere il carico del debito pubblico attraverso consistenti manovre di tagli alla spesa pubblica ed aumento dell’imposizione fiscale – sono state le grandi protagoniste dell’anno che sta per concludersi, supportate dall’idea che alla base dei “debiti sovrani” vi fosse una “finanza pubblica malata”, espressione di un settore pubblico ingombrante e non adeguato a creare gli stimoli giusti per la crescita economica. Per rafforzare le ragioni che indicavano tali politiche come le uniche percorribili, conferendo loro ampia legittimazione nonché consenso, è stato ripetutamente sostenuto (financo ai limiti dell’ossessione) che – in misura diversa – i paesi europei sono “vissuti al di sopra delle proprie possibilità”, e che con il sopraggiungere della crisi economica era dunque giunto il momento di intraprendere la strada della “disciplina di bilancio”, a maggior ragione nelle economie più critiche della cosiddetta “periferia europea”, rappresentate essenzialmente da Spagna, Portogallo, Grecia e Italia. Sta di fatto che – come era lecito attendersi – queste politiche hanno mostrato tutti i loro limiti, avendo sortito effetti recessivi più o meno gravi sulle dinamiche della crescita economica, che non hanno fatto altro che da leva per ulteriori aumenti dell’onere del debito, sia in termini assoluti sia in termini relativi (in ragione del maggior peso che un debito anche di entità più ridotta può assumere su valori decrescenti del reddito nazionale). E si tratta di un fallimento talmente evidente, che nemmeno le maggiori istituzioni internazionali – come il Fondo Monetario Internazionale - si sono potute esimere dal riconoscerlo.

In questa vicenda c’è però qualcosa di ancor più importante, che troppo è stato (ed è per lo più) ancora taciuto: una diagnosi sbagliata della crisi, che affonda le proprie radici in una mistificazione delle vere cause all’origine dell’esplosione dei “debiti sovrani”. Non è certamente secondario valutare la dannosità (peraltro “annunciata”, a dispetto di qualsiasi fola in circolazione sull’ “austerità espansiva”) delle politiche del “rigore di bilancio”, ma risalire alle cause prime del dissesto in corso ed identificare quelli che sono i reali fattori di pressione sullo “spread” (e dunque – indubbiamente - sul peggioramento della situazione debitoria) è fondamentale per poter correttamente individuare lo spazio e la direzione di politiche di intervento che consentano non solo il superamento della crisi (nel breve periodo), ma anche l’innesco di processi di crescita duratura (nel lungo periodo).

Il primo passo sta innanzitutto nel riconoscere che la “crisi dei debiti sovrani” è figlia legittima del debito privato, uno “tsunami” che allo scoppio della crisi finanziaria internazionale sul finire del 2008, ha visto costretti i governi delle maggiori economie occidentali ad intervenire pesantemente in operazioni di salvataggio del sistema bancario. Addebitare ad una sorta di “statalismo scellerato” la crisi dei “debiti sovrani” è pertanto – innanzitutto – falso. Le statistiche sui bilanci pubblici parlano chiaro in tal senso (fatta salva, naturalmente, la vicenda tutta peculiare della Grecia, in cui si è palesemente riscontrato un “falso in bilancio” di natura pubblica), mostrando peraltro come in Europa le situazioni debitorie pubbliche dei paesi “periferici” fossero in taluni casi (Spagna) persino più contenute di quella dell’economia tedesca, notoriamente “paladina” del “rigore” e della “disciplina di bilancio”. Questo ci dice, pertanto, che non esiste – né è esistita prima – una sorta di “crisi endemica” dei bilanci pubblici e che – data la reale causa dei presenti dissesti – i problemi relativi ai margini di manovra per interventi pubblici “espansivi” sono da ricercarsi altrove: in Europa, in particolare, nell’assenza di un bilancio federale e di una Banca Centrale deputata a fungere - come dovrebbe - da “prestatore di ultima istanza”, non essendo tali istituti previsti nell’attuale costruzione dell’euro, diversamente da quanto si riscontra nell’economia degli Stati Uniti.

Il secondo passo da compiere sta nell’intercettare la direzione che politiche di intervento pubblico dovrebbero intraprendere, nel senso di creare in ciascun paese le migliori condizioni permissive per il suo sviluppo. Accertato che il mercato non possiede capacità di autoregolazione – contrariamente agli assunti delle teorie liberiste che hanno dominato nel corso degli ultimi trenta anni e che a tutt’oggi sono il fulcro del cosiddetto mainstream economico – il problema sta nel comprendere come attivare i meccanismi di traino della domanda aggregata, sia essa interna o estera. Ed è questo un passaggio cruciale: si tratta infatti di un’operazione che chiama in campo una strumentazione molto ampia, che dovrebbe correggere tanto i deficit di domanda interna – determinati spesso anche da una distribuzione del reddito sfavorevole ai redditi medio-bassi con più alta propensione al consumo – quanto quelli di domanda estera, che si giocano non solo sul traino diretto esercitato dalle esportazioni, ma anche sulla capacità di queste di equilibrare le importazioni, dando luogo – a seconda dei casi – a surplus o deficit commerciali, o in altri termini a domanda “netta” estera positiva o negativa. La valenza dei saldi commerciali è inoltre particolarmente importante, poiché è in funzione di essa che si determina la posizione creditoria o debitoria dei paesi sull’estero, concorrendo a definire la posizione debitoria o creditoria complessiva di ciascun paese.

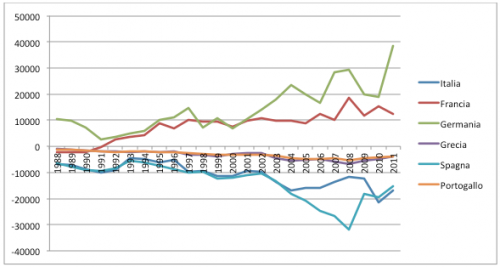

Nel quadro della situazione europea sono in effetti le posizioni debitorie/creditorie complessive a differenziare “strutturalmente” le economie dei diversi paesi, e a caratterizzare in particolar modo la debolezza dei paesi periferici. E se di “endemicità” del debito si vuole parlare, è al debito estero che bisogna guardare, facendo riferimento ad un periodo esteso antecedente la crisi. Emerge così – nitidamente – la criticità delle economie dei paesi “periferici” in un lasso di tempo sufficientemente esteso tale da escludere che l’unica causa della fragilità dei conti con l’estero debba essere ricercata nelle forti politiche deflative sui salari messe in campo dalla Germania per acquisire competitività all’interno dell’area euro. Tra i “nervi scoperti” dei deficit esteri dei paesi periferici, significativa appare in particolare la debolezza competitiva nei settori manifatturieri high-tech, per i quali la dinamica della domanda mondiale risulta crescente e accelerata dalla seconda metà degli anni ’80 . Una rinnovata attenzione per il ruolo propulsivo rivestito dallo sviluppo di un settore manifatturiero innovativo induce a guardare con grande attenzione a questo “debito estero” di lungo periodo, che fa da cartina al tornasole di importanti carenze strutturali delle economie di questi paesi, e dunque del maggior/minor grado di forza/debolezza sistemica di ciascun paese che tale stato di cose riflette, con conseguenze di rilievo sulle valutazioni degli investitori.

Saldi commerciali nei prodotti high-tech (milioni di $ correnti)

Saldi commerciali nei prodotti high-tech (milioni di $ correnti)

Fonte:

Osservatorio Enea sulla Competitività Tecnologica

La situazione dell’Italia – coerente in tendenza con quella degli altri paesi della periferia d’Europa – appare oltremodo critica, tenuto conto della sua dimensione economica e del ruolo portante tradizionalmente rivestito nella sua struttura produttiva dal settore manifatturiero . La crisi di competitività italiana – come già diffusamente ricordato nei precedenti interventi di Pietro Greco e di Sergio Ferrari - è ben antecedente all’attuale crisi e viene da lontano, esprimendo il mancato adattamento del sistema produttivo ai nuovi paradigmi dell’innovazione tecnologica. L’assenza di interventi di politica industriale tesi a riconfigurare la specializzazione produttiva dell’Italia verso settori a maggior intensità tecnologica, ha col tempo reso sempre più oneroso il deficit commerciale derivante dagli scambi di prodotti high-tech del nostro Paese. L’onere – per così dire – strutturale di importazioni di beni ad alta tecnologia del tutto “fisiologiche” per un paese industriale avanzato quale è il nostro, è stato – soprattutto a partire dalla seconda metà degli anni ’80 – sempre meno compensato dalle esportazioni, mentre a livello di bilancia manifatturiera complessiva ha iniziato a pesare la minor domanda mondiale rivolta ai prodotti di tipo “tradizionale”, con l’aggravante che dopo l’entrata nell’euro non è stato più possibile mettere mano a manovre svalutative e sempre maggiori si sono fatte le pressioni sul mercato del lavoro, favorendo la precarizzazione dell’occupazione e di qui la spinta al ribasso sui salari per recuperare in competitività. La crisi competitiva dell’Italia –nel confronto con i maggiori paesi europei e con le economie del Nord - Europa – come già ricordato nei precedenti interventi – si è configurata come “crisi specifica”, che non può, evidentemente, non gravare sull’esito della crisi più generale che sta investendo l’Europa tutta. Ma sarebbe errato non circoscriverla entro i caratteri che le sono propri e che – come visto – alimentano “strutturalmente” l’onere del debito estero.

All’oblio in cui sono state relegati i processi dell’economia reale, in un contesto in cui la finanza sembra essere d’un tratto diventata l’alfa e l’omega di tutte le vicende economiche, deve essere – in generale -posto un fine, e il caso italiano deve ricevere ancora maggior attenzione. Decenni di mancati interventi di politica industriale, unitamente all’abbandono dell’investimento pubblico in ricerca, hanno prodotto un’endemica fragilità del debito estero dell’Italia, l’esemplificazione più netta di un paese che “consuma” innovazione ma che non ne produce a sufficienza da rendere sostenibile il suo status di economia industriale avanzata. La grande sfida che immediatamente deve essere lanciata in nome della “guerra” allo “spread” – e dunque in nome di prospettive di rilancio dell’economia e di sviluppo duraturo – non può dunque non partire che da un’attenzione per politiche di intervento pubblico significativamente focalizzate sul rilancio degli investimenti in ricerca e sulla rigenerazione del tessuto industriale in settori a più “alta intensità tecnologica”, con ciò intendendo una reale riedizione dei settori produttivi e non, come spesso erroneamente si argomenta, la messa in atto di correttivi finanziari volti ad incentivare le spese in ricerca e sviluppo delle imprese. Le componenti scientifiche e tecnologiche del sistema italiano non sono infatti seconde per qualità a quelle degli altri maggiori paesi europei (Oecd, STI Outlook 2012), ma non rappresentano una massa critica adeguata a rendere competitivo il Paese, innalzandone il potenziale di sviluppo. Di tempo ne è stato perso già molto, ma – a maggior ragione -è questa la strada che deve essere intrapresa al più presto per non rischiare che il Paese registri ritardi ancor più significativi alla ripresa del ciclo internazionale e non sia in grado di cogliere tutte quelle opportunità che con i nuovi contesti tecnologici – quali ad esempio quelli prospettati dalle necessità della riconversione ambientale – si stanno prefigurando all’orizzonte.