Nel XX secolo, in particolare dopo la fine della seconda guerra mondiale, si è verificata una transizione netta nel modo di fare scienza: se Ernest Rutherford all’inizio del ‘900 poteva esplorare le proprietà dell’atomo con una strumentazione che stava tutta sul suo tavolo, oggi per studiare i componenti della materia sono necessarie le enormi apparecchiature del Large Hadron Collider al CERN. Sono aumentati incredibilmente i costi degli esperimenti e le dimensioni dei gruppi di lavoro, imponendo un cambiamento nel modo in cui la scienza percepisce se stessa: non più in altera solitudine ma bisognosa di consenso popolare e finanziamenti pubblici e privati; non più fantasiosa e pionieristica, ma fortemente programmata e gerarchizzata.

Come la nascita e lo sviluppo della Big Science abbiano modificato la struttura della scienza e la sua rappresentazione è questione che non si può evitare di approfondire, soprattutto considerando l’enorme impatto che la ricerca tecno-scientifica ha avuto e sta avendo sulla contemporaneità.

Sviluppo della Big Science

Il 17 gennaio 1961 il Presidente USA Eisenhower, nel suo discorso di commiato, avvertiva:

“La rivoluzione tecnologica negli ultimi decenni è stata (…) in gran parte responsabile dei cambiamenti radicali nel nostro complesso militare-industriale. In questa rivoluzione la ricerca ha assunto un ruolo centrale ed è diventata anche più formalizzata, complessa e costosa. Una quota sempre crescente viene condotta per, da, o sotto la direzione del governo federale. Oggi, l'inventore solitario, che armeggia nel suo laboratorio, è stato oscurata da task force di scienziati, nei laboratori e nei test sul campo. Allo stesso modo l'università libera, storicamente fonte di libere idee e scoperte scientifiche, ha vissuto una rivoluzione nella conduzione della ricerca. In parte a causa dei costi elevati, avere un contratto governativo diventa praticamente un sostituto alla curiosità intellettuale. Per ogni vecchia lavagna, ora ci sono centinaia di nuovi calcolatori elettronici. La prospettiva di un condizionamento degli studiosi della nazione tramite le offerte di lavoro federale, gli stanziamenti per i progetti e il potere del denaro è sempre presente - ed è da considerare seriamente. Eppure, nel tenere in dovuto conto la ricerca scientifiche e le scoperte, come dovremmo, dobbiamo anche essere attenti al pericolo uguale e contrario che la politica pubblica possa diventare prigioniera di una élite scientifico-tecnologica. E’ compito degli uomini di stato modellare, bilanciare e integrare queste e altre forze, nuove e vecchie, nell'ambito dei principi del nostro sistema democratico - sempre puntando verso gli obiettivi supremi della nostra società libera.”

Il Presidente guardava con occhi preoccupati lo sviluppo di una scienza con nuove caratteristiche, a suo avviso ipertrofica e pericolosa. La novità nel modo di fare ricerca scientifica era rappresentata dalla nascita di progetti con caratteristiche inedite: grandi staff, grandi macchine e grandi centri di ricerca, enormi finanziamenti. Sebbene già negli anni ’30 fossero stati realizzati progetti di grandi dimensioni, come il Radiation Laboratory a Berkeley per lo studio della fisica del ciclotrone, è durante la Seconda Guerra Mondiale che questo fenomeno ha acquistato piena evidenza, al punto da indurre politici e scienziati a sentirsi inquieti. E’ noto come essa sia spesso stata definita “la guerra dei fisici” per il contributo determinante che lo sviluppo scientifico ha dato al progresso militare, in particolare con l’invenzione del radar, e della bomba atomica da parte del Progetto Manhattan; lo sforzo in termini finanziari e di risorse umane fu enorme.

Considerando che ci si trovava in tempo di guerra, si potrebbe attribuire un sacrificio così pronunciato da parte del governo federale all’urgenza di acquisire una superiorità militare: se così fosse stato, si sarebbe trattato di un caso unico e i metodi della Big Science sarebbero stati abbandonati in tempo di pace. In realtà, si tratta di un modello che ha avuto crescente successo negli anni successivi: l’esplorazione spaziale e l’impresa dello sbarco sulla Luna, gli studi sulla fusione nucleare, la costruzione dei grandi acceleratori di particelle e, nel campo delle scienze della vita, il Progetto Genoma Umano.

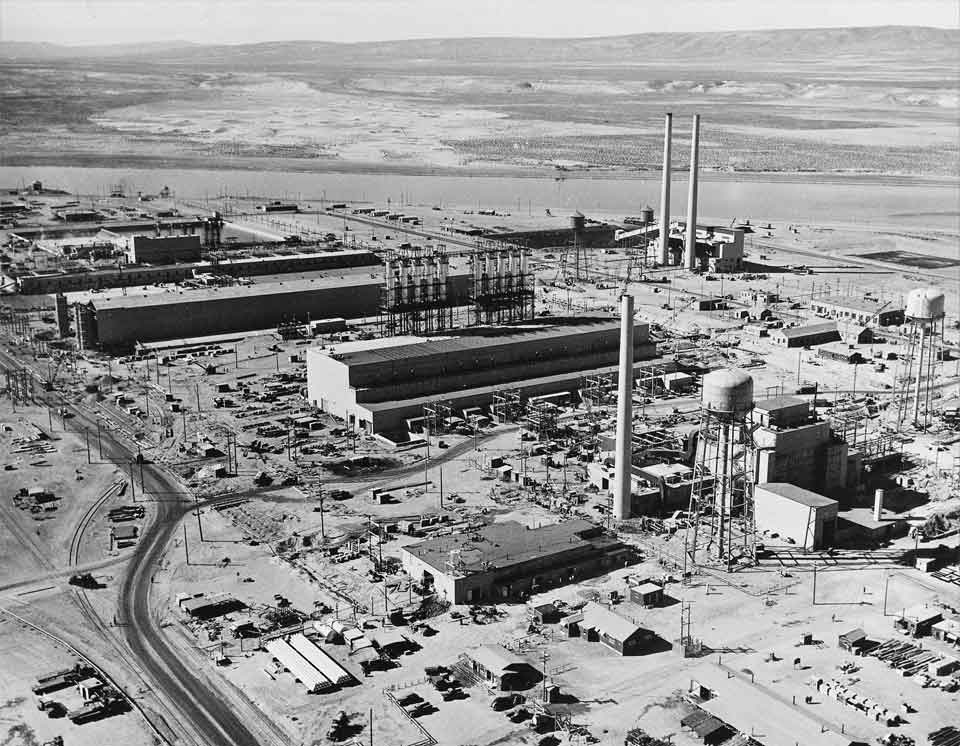

Il Progetto Manhattan

Il “Progetto Manhattan” fu il programma di ricerca militare che realizzò le prime bombe atomiche durante la Seconda Guerra Mondiale. Fu operativo dal 1942 al 1946; venne istituito con budget e personale modesti nel 1939, crescendo fino a occupare 130000 persone e a raggiungendo un costo complessivo di 2 miliardi di dollari (equivalenti a circa 24 miliardi di dollari del 2011), di cui il 90% fu speso per materiali e infrastrutture e il 10% per sviluppo e produzione della bomba. Al progetto collaborarono diversi fisici importanti: L. Szilàrd, E. Wigner, E. Teller, E. O. Lawrence, A. Compton, H. Bethe, f. Bloch, E. Segrè, E. Fermi tra gli altri; il responsabile del programma specificamente dedicato alla costruzione della bomba, il “Progetto Y”, fu J. R. Oppenheimer. Più di 30 siti tra Stati Uniti, Regno Unito e Canada ospitarono i laboratori e le infrastrutture per il progetto; alcuni di questi furono reimpiegati dopo la guerra per la ricerca e andarono a formare il primo nucleo della rete dei Laboratori Nazionali Statunitensi: Lawrence Berkeley, Los Alamos, Oak Ridge, Argonne e Ames.

Il primo ordigno nucleare ad essere testato sul campo esplose ad Alamogordo in New Mexico il 16 luglio 1945 (Trinity Test). Meno di un mese dopo furono sganciate le due bombe atomiche su Hiroshima e Nagasaki. Il commento di Oppenheimer alle operazioni militari fu la celebre riflessione: “I fisici hanno conosciuto il peccato”. Dopo la guerra, il Progetto Manhattan fu anche responsabile dei test nucleari all’atollo di Bikini, sviluppò nuove armi, promosse la realizzazione di una rete di laboratori federali, incentivò la ricerca medica in campo radiologico e gettò le fondamenta per la marina nucleare. Mantenne il controllo sulle armi atomiche statunitensi fino alla formazione della United States Atomic Energy Commission nel gennaio del 1947.

L’esplorazione dello spazio e lo sbarco sulla Luna

L’esplorazione dello spazio fu uno dei terreni su cui si misurarono Stati Uniti e Unione Sovietica durante la guerra fredda. Il primo oggetto umano a essere lanciato in orbita attorno alla Terra fu il sovietico Sputnik 1 il 4 ottobre 1957. Subito dopo il lancio dello Sputnik, gli Stati Uniti temettero di perdere il primato tecnologico e il presidente Eisenhower costituì il 29 luglio 1958 la NASA (National Aeronautics and Space Administration), che assorbiva l’agenzia precedente (NACA) con tutti i suoi 8000 lavoratori, le sue infrastrutture e il suo budget da 100 milioni di dollari l’anno. Un contributo significativo alla nuova agenzia fu dato dall’acquisizione delle conoscenze tecnologiche naziste sviluppate da Wernher von Braun, che divenne poi un dirigente della NASA. Dopo i successi del programma spaziale sovietico (oltre all’orbita dello Sputnik 1, primo essere vivente in orbita nel 1957 e primo uomo in orbita, Yuri Gagarin, nel 1961) l’amministrazione USA decise di imprimere un’accelerazione alla propria “corsa allo spazio” che portò a replicare i successi russi e a raggiungere il primo allunaggio umano con la missione “Apollo 11” il 20 luglio del 1969.

Il programma Apollo, inaugurato nel 1961 e concluso nel 1972, fu uno dei più dispendiosi programmi scientifici americani: si stima sia costato l’equivalente di 191 miliardi di dollari attuali. Dopo lo sbarco sulla Luna, che i sovietici non riuscirono mai a replicare, i fondi concessi alla NASA diminuirono drasticamente: il programma spaziale continua ancora oggi, ma l’obiettivo politico della supremazia tecnologica nella Guerra Fredda era stato raggiunto.

Gli studi sulla fusione nucleare

L’idea di produrre energia tramite fusione nucleare, eliminando il problema delle scorie intrinseche al meccanismo di fissione, è stata concepita fin dai tempi del progetto Manhattan, e realizzata dall’uomo, ad oggi, solo con la detonazione delle bombe H negli anni ’50 e ’60. Il problema principale per ottenere la fusione di due nuclei atomici è rappresentato dall’energia necessaria a farli avvicinare al punto da fondersi, realizzando l’”ignizione” del processo: le bombe H includevano a questo scopo un ordigno nucleare a fissione che, esplodendo, dava il via alla reazione di fusione in grado di liberare energia. Allo scopo di un utilizzo civile dell’energia da fusione, a partire dagli anni ’60 si cercarono di raggiungere le condizioni necessarie all’ignizione, tramite lo sviluppo di laser ad alta energia. All’inizio degli anni ’70 iniziarono i primi esperimenti al Lawrence Livermore National Laboratory. Nel frattempo, stimolati dalle crisi petrolifere, grandi finanziamenti furono dedicati allo sviluppo dei progetti di energia da fusione.

Una tappa fondamentale fu la realizzazione del laser Shiva nel 1978, seguito dal laser Nova nel 1984, costati rispettivamente l’equivalente di 81 milioni e 200 milioni di dollari: entrambi, pur dando significativi contributi allo studio del fenomeno, non raggiunsero l’ignizione. La fine della Guerra Fredda cambiò le priorità dei finanziamenti e una proposta di upgrade del laser Nova (del costo previsto di 1 miliardo di dollari) venne rifiutata dal Congresso. A questo punto, tuttavia, gli Stati Uniti si trovavano nelle condizioni di scegliere tra perdere una generazione di studiosi e tecnici nucleari, necessari per il mantenimento degli armamenti atomici, o intraprendere lo sviluppo di nuovi ordigni, con il vincolo tuttavia di non essere costretti a testarli in atmosfera: gli studi sulla fusione assolvevano in parte a questo compito. Nuovi finanziamenti furono quindi destinati alla realizzazione della National Ignition Facility (NIF), completata nel 2009 al costo di 4.2 miliardi di dollari, presso il Lawrence Livermore National Laboratory e tuttora in funzione.

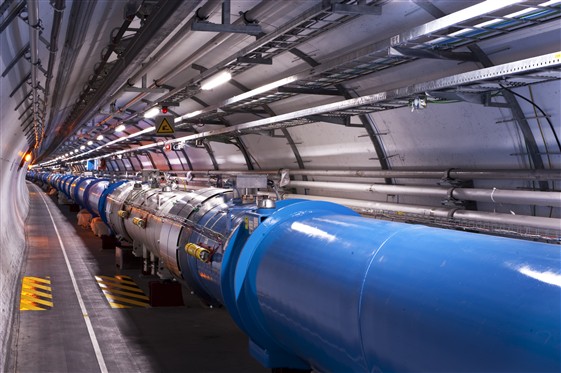

I grandi acceleratori di particelle

Gli acceleratori di particelle sono stati fin dai primi decenni della fisica atomica gli strumenti principali di studio della struttura della materia. La loro evoluzione viene solitamente classificata tramite l’energia crescente che queste macchine riescono a raggiungere: maggiore è l’energia, minori sono le dimensioni delle particelle che si riescono ad osservare; inoltre, dato che diverse di esse non esistono allo stato libero, ma aggregate in particelle più grandi, l’esperimento deve fornire anche l’energia per spezzare i legami nucleari che le tengono assieme.

Il primo ciclotrone, un acceleratore circolare di 10 cm di diametro, fu realizzato nel 1929 da E. Lawrence a Berkeley. In seguito ne costruì altri più grandi, che vennero utilizzati anche per i processi di separazione degli isotopi di uranio nell’ambito del Progetto Manhattan. I ciclotroni utilizzano una combinazione di campo magnetico e radiofrequenza per accelerare le particelle e piegarne l’orbita che risulta efficace fintantoché non si entra in regime relativistico: superato questo limite la particella allarga la sua orbita e tende a sfuggire dalla macchina acceleratrice. Furono quindi sviluppate macchine più raffinate come i sincrociclotroni, i ciclotroni isocroni e i betatroni (1940, Widerøe), fino a giungere allo sviluppo dei sincrotroni, le macchine usate ancora oggi. Queste possono essere a raggio fisso e quindi raggiungere grandi dimensioni (l’anello del CERN è di 27 km) e grandi energie, pur non accelerando le particelle in modo continuo ma “a pacchetti”. Gli acceleratori possono essere anche di forma lineare, ma presentano il difetto di potere aumentare l’energia disponibile solo incrementando la lunghezza della macchina. SLAC (Stanford Linear ACcelerator), il più importante acceleratore lineare tuttora operativo è lungo 3 km e fu costruito nel 1966. E’ in progetto la realizzazione di un nuovo acceleratore lineare lungo 40 km, che dovrebbe essere costruito tra il 2015 e il 2020 e costare quasi 7 miliardi di dollari (ILC, International Linear Collider). Attualmente le macchine ad alte energie sono complessi di acceleratori collegati tra loro: acceleratori lineari per la creazione iniziale del pacchetto, sincrotroni a bassa energia per l’accumulo delle particelle e infine il grande anello per l’accelerazione vera e propria e l’esperimento.

Il complesso del CERN è attualmente il più grande acceleratore in funzione, dopo la chiusura del Tevatron a Brookhaven per problemi di budget il 30 settembre 2011. Fondato nel 1954, conta 2400 impiegati a tempo pieno e quasi 8000 ricercatori da più di 600 università e 113 nazioni; il suo budget per il solo anno 2008 è stato di circa 650 milioni di euro. In questo momento l’anello sotterraneo tra Svizzera e Francia ospita il Large Hadron Collider (LHC) che, con un budget di 7.5 miliardi di euro è una delle più costose macchine scientifiche mai costruite.

Il Progetto Genoma Umano

Il progetto di identificare fisicamente e funzionalmente i geni che compongono il DNA umano si è sviluppato negli anni ’80 ed è stato formalizzato nel 1990 dal governo statunitense con il Progetto Genoma Umano che, con un budget di 3 miliardi di dollari, aveva un tempo di lavoro previsto di 15 anni, coinvolgendo ricercatori da USA, Gran Bretagna, Francia, Germania, Giappone, Cina e India.

Nel 1998 un’azienda privata, la Celera Genomics fondata da Craig Venter, un ex scienziato dell’NIH statunitense (National Institue of Health), annunciò che avrebbe sequenziato il genoma umano più velocemente del gruppo finanziato dal governo a un decimo del costo: 300 milioni di dollari contro 3 miliardi. Entrambi i gruppi riuscirono nell’impresa, annunciando il successo contemporaneamente nel febbraio 2001. La competizione, in effetti, si dimostrò molto stimolante per lo sviluppo della ricerca, al punto da portare a concludere il lavoro prima del previsto. Ci fu una controversia nata dalla volontà della Celera di brevettare “solo 200 o 300” geni, che fu bruscamente risolta nel marzo 2000 dal Presidente Clinton con la dichiarazione che il il genoma umano non poteva essere brevettato. Il titolo Celera crollò in borsa, ma la decisione garantì il pubblico accesso ai dati e il loro corretto uso.

Big Science come patologia della scienza?

La comparsa dei progetti Big Science sulla scena della ricerca scientifica ha provocato diverse reazioni e critiche, dall’interno e dall’esterno del mondo della scienza.

Il Presidente Eisenhower, nel suo discorso di commiato, sollevava di fatto la questione, puntando il dito verso il doppio rischio di un condizionamento della ricerca da parte del governo tramite l’elargizione dei finanziamenti, e di una dipendenza dello stato da un’élite di scienziati che attraverso la ricerca scientifica detengano il controllo dello sviluppo economico. Gli risposero a stretto giro il fisico A.M. Weinberg sul fronte interno alla scienza e D.J. De Solla Price dal punto di vista dell’analisi storica e sociologica del fenomeno.

Weinberg: “Is Big Science ruining us?”

Il fisico A. M. Weinberg, in risposta all’avvertimento di Eisenhower, pubblicò su Science il 21 luglio 1961 un articolo in cui analizzava le questioni poste dalla Big Science (in questo articolo egli fu il primo a utilizzare questa espressione) in un’ottica piuttosto pessimistica, nonostante la grandiosa celebrazione con cui iniziava:

“Quando la storia guarderà al XX secolo, vedrà la scienza e la tecnologia come sue caratteristiche principali; vedrà nei monumenti della Big Science – gli enormi razzi, gli acceleratori alle alte energie e i reattori da ricerca ad alto flusso – i simboli del nostro tempo, come sicuramente troverà in Notre Dame un simbolo del Medio Evo. (…) Noi costruiamo i nostri monumenti nel nome della verità scientifica, essi costruirono i loro nel nome della verità religiosa; noi usiamo la nostra Big Science per dare prestigio al nostro paese, essi usavano le loro chiese per dare prestigio alle loro città; noi costruiamo per placare quella che l’ex presidente Eisenhower suggeriva potrebbe diventare una casta dominante, essi costruirono per compiacere i preti di Iside e Osiride.”

La prima questione che si pone Weinberg nell’articolo è interna alla scienza: “Is Big Science Ruining Science?” (“La Big Science sta rovinando la scienza?”). Dato che la Big Science ha bisogno di grandi finanziamenti pubblici, deve cercare di costruirsi un consenso sociale negli ambienti politici e nell’opinione pubblica e questo costringe gli scienziati ad acquisire capacità giornalistiche, a confondere la pubblicazione scientifica con la stampa popolare e la stanza della commissione federale con la sala congressi della società scientifica.

In secondo luogo i ricercatori, data la larga disponibilità di finanziamenti, avranno meno stimoli a ridurre la complessità dei problemi per rendere gli esperimenti economicamente accessibili, come era successo ai tempi della scienza pioneristica: tenderanno a “spendere soldi invece di pensieri”. Infine gli scienziati per gestire progetti di grandi dimensioni devono acquisire capacità amministrative e, secondo Weinberg, “sfortunatamente la scienza dominata dagli amministratori è scienza compresa dagli amministratori, e tale scienza velocemente diventa attenuata se non priva di senso.”

Weinberg, insomma, ritiene che la Big Science stia rovinando le università, trasformando gli scienziati da studiosi e professori in scienziati “amministratori, domestici e pubblicisti”. Egli propone di confinare i grandi apparati della Big Science nei Laboratori Nazionali, a controllo federale (come quello di Oak Ridge da lui diretto) in quanto questi avrebbero imparato già da tempo a trovare un equilibrio tra necessità scientifiche, amministrative, giornalistiche e finanziarie: in questo modo si potrebbe evitare il “diffondersi del contagio” alle università.

La seconda questione posta da Weinberg nell’articolo era: “Is Big Science Ruining Us Financially?”, ovvero si domandava se i finanziamenti copiosamente destinati alla ricerca fossero sostenibili. In effetti tra l’inizio e la fine della seconda guerra mondiale la spesa destinata a ricerca e sviluppo dal governo statunitense aumentò di un ordine di grandezza, continuando a crescere negli anni post-bellici del 10% ogni anno: più del doppio rispetto alla crescita del prodotto interno lordo. Weinberg propone che i finanziamenti si debbano limitare a crescere allo stesso ritmo del PIL nazionale e che le scelte sulla destinazione dei fondi siano effettuate all’interno della comunità scientifica, secondo il principio di responsabilità degli scienziati. Egli si mostra molto critico verso le scelte federali di intraprendere l’esplorazione spaziale e la costruzione di grandi acceleratori: si tratta a suo parere di imprese incredibilmente dispendiose, pericolose e poco rilevanti per la vita delle persone; al contrario si dichiara convinto che il campo più promettente sia rappresentato dalla biologia molecolare, su questioni come la cura del cancro e la creazione della vita in laboratorio (che ritiene probabile prima della fine del secolo), oltre ai temi tecnologici posti dalla crescente pressione della popolazione sulle risorse: energia (nucleare), acqua, inquinamento.

De Solla Price: la Big Science è l’evoluzione naturale della Little Science

Il fisico e storico della scienza Derek J. De Solla Price poco più di una anno dopo l’articolo di Weinberg, tenne una serie di conferenze al Brookhaven National Laboratory sul tema dell’evoluzione da Little a Big Science, argomentando che non si è trattato di un cambiamento rivoluzionario ma di una transizione graduale e assimilabile alla crescita della popolazione scientifica. Egli basa le sue affermazioni sullo studio del numero di pubblicazioni scientifiche dal 1660, considerandolo un ragionevole indicatore della crescita della scienza stessa. Dalla nascita della scienza moderna al 1960, rileva l’autore, l’andamento delle pubblicazioni scientifiche è stato di tipo esponenziale, analogo alla crescita del personale scientifico. La seconda guerra mondiale ha rappresentato nell’andamento regolare della crescita solo una fluttuazione, verificabile dal fatto che il trend esponenziale di prima e dopo gli eventi bellici è uguale: durante la guerra i dati sulle pubblicazioni e sul personale possono essere stati alterati per motivi di segretezza e di impiego militare degli scienziati. L’andamento esponenziale, poiché non è possibile nei sistemi reali una crescita infinita, rappresenta solo la prima parte della curva realistica di crescita delle popolazioni in natura. E’ evidente che il fenomeno è destinato prima o poi a rallentare fino a raggiungere la saturazione: si parla di curva “logistica” di crescita di una popolazione. De Solla Price ipotizza che nel 1960, quando lui parla, ci si trovi al termine dell’andamento puramente esponenziale: nel giro di una generazione la scienza, secondo la sua analisi, avrebbe perso definitivamente il carattere di crescita esponenziale per avvicinarsi al valore di saturazione senile. Questo fenomeno in natura può avvenire in modo regolare, oppure “a gradini”, o ancora tramite violente oscillazioni, o persino non avvenire proprio (perdita di definizione o estinzione), a seconda del fenomeno osservato. L’apparizione di nuovi elementi nei rapporti scienza-società sembra effettivamente confermare l’ipotesi di una transizione in atto tra la crescita costante del passato e una nuova scienza futura, che si baserà su regole nuove e differenti per non scomparire.

Tra le caratteristiche della Big Science, la crescita dei bilanci è, nell’analisi di De Solla Price, un effetto diretto della crescita della popolazione scientifica. La formazione di gruppi di lavoro sempre più ampi rispecchia invece un fenomeno simile alla tendenza dell’inurbazione per il popolamento: al crescere della popolazione di uno stato, le persone tendono a raggrupparsi in unità strutturate come le città piuttosto che diffondersi uniformemente sul territorio. Anche la scienza presenta questa tendenza alla cristallizzazione, in cui realtà grandi crescono a spese di quelle più piccole. Inoltre, dato l’aumento della richiesta di personale scientifico, tenderà ad aumentare il numero di scienziati meno brillanti, mentre il numero di talenti superiori crescerà meno rapidamente: è naturale quindi che questi tendano a diventare i leaders di grandi gruppi di ricerca composti dai primi. E’ evidente, quindi, come risulti cambiato il ruolo dello scritto scientifico: non più comunicazione a tutti di una conoscenza, ma costruzione di un ruolo all’interno di un gruppo ristretto e informale di pari, coloro che nel mondo si occupano dello stesso settore disciplinare; la comunicazione vera e propria all’interno del gruppo avviene da persona a persona, durante incontri, conferenze o contatti personali, mentre con la pubblicazione si “segna il passo” sull’oggetto della propria indagine. Effettivamente, ammette De Solla Price, mentre la crescita della comunità scientifica ha sperimentato una crescita graduale, si è verificata una discontinuità in coincidenza con la seconda guerra mondiale: l’aumento inedito dei finanziamenti alla ricerca scientifica. Si tratta di un effetto, argomenta, dell’avvicinarsi alla saturazione: pur aumentando gli investimenti in ricerca, una crescita reale risulta sempre più difficile da ottenere. Gli scienziati, conclude De Solla Price, hanno appena cominciato ad accorgersi di aver tra le mani una considerevole quantità di potere: solo di recente hanno iniziato a partecipare al dibattito pubblico e politico. Essi hanno il dovere di essere responsabili nei confronti della società, avviando una ricostruzione del tessuto sociale della scienza e praticando una gestione del potere all’interno degli schemi del controllo democratico.

In conclusione...

Le analisi riportate sulla transizione da Little a Big Science mostrano come, mentre nessuno nega che un cambiamento sia avvenuto, questo non si possa comprendere solo come un mutamento di scala, ma abbia conseguenze profonde sull’organizzazione interna della scienza e sui suoi rapporti con la società. In particolare, Big Science non significa semplicemente maggiori investimenti, ma crescente concentrazione in un limitato numero di centri di ricerca, e la nascita di infrastrutture appositamente dedicate a specifici obiettivi di studio. In secondo luogo, in queste istituzioni centralizzate il lavoro nei laboratori è altamente specializzato: la divisione non è soltanto tra scienziati teorici, sperimentali e ingegneri, ma anche in gerarchie di responsabili di gruppi, manager di laboratori e coordinatori del lavoro.

Infine la Big Science dipende fortemente dalla percezione sociale e politica della rilevanza dei propri progetti, in termini di ricadute sanitarie, militari, industriali o di prestigio nazionale. Questo continuo processo di giustificazione ha influenzato la comprensione dei ricercatori del proprio lavoro e in ultima analisi anche del suo contenuto intellettuale. La scienza contemporanea ha intrecciato un rapporto con la società con caratteristiche sempre più spiccate di mutua dipendenza, perciò non può pensare di sopravvivere in isolamento. Se gli scienziati non prenderanno atto delle mutate condizioni in cui si trovano a lavorare, come ammonisce De Solla Price, l’attività scientifica potrebbe anche non raggiungere una stabile età senile, perdendo definizione o addirittura scomparendo.