Stiamo forse vivendo un periodo di emergenza terremoti?

Con una media di 1000 morti/anno in Italia dall’Unità a oggi e di 80.000 morti/anno nel mondo negli ultimi dieci anni, i terremoti sono il più sanguinoso fenomeno geologico su scala globale. In realtà, questi valori medi sono il risultato di pochi eventi catastrofici che tendono a ripetersi a volte in sequenze temporalmente ravvicinate: per esempio il terremoto di Messina e Reggio Calabria del 1908 e quello di Avezzano del 1915 sono stati responsabili da soli di 100.000-120.000 vittime. In Italia, con una media di un terremoto catastrofico ogni dieci anni dall’Unità a oggi, abbiamo da sempre convissuto con i terremoti. Il bilancio a scala globale dovrebbe peggiorare nel XXI secolo, non per un incremento del numero di grandi terremoti per decade, ma per il continuo aumento della popolazione mondiale, spesso sita in località vulnerabili da eventi sismici. Benché l’ultimo decennio sia stato funestato da eventi distruttivi, non abbiamo dati statisticamente significativi che mostrino un incremento dell’attività sismica su scala mondiale. Purtroppo, alcuni degli eventi medio-grandi (terremoto di magnitudo M 7.1 di Van 2011, Turchia, 604 vittime) e giganteschi (il terremoto M 9.0 del Giappone 2011, 20.000 tra morti e dispersi) hanno devastato aree densamente abitate e avuto grande risalto nei mass media. Ma immagino nessuno di voi abbia sentito parlare del terremoto M 7.1 che ha colpito la Papua Nuova Guinea il 14 Dicembre del 2011. Eppure di terremoti così grandi ne abbiamo almeno uno al mese sulla Terra, e uno grande come quello dell’Aquila 2006 (M 6.3) ogni tre giorni: non è un momento di particolare emergenza terremoti.

Ma cosa sappiamo sui terremoti?

I terremoti mortali per l’uomo “enucleano” tra i 6 km e i 30 km di profondità. Trattandosi di un fenomeno che avviene a diversi chilometri di profondità, la sismologia, che studia i terremoti mediante l’interpretazione delle onde sismiche, la fa da padrona. La sismologia quantitativa è una disciplina modernissima: nasce con l’installazione dei primi sismometri nella seconda metà dell’800. Grazie soprattutto al contributo di studiosi Giapponesi e Statunitensi, furono localizzati (ipocentri) e quantificata l’energia sismica (M = magnitudo) irradiata dai terremoti. In questo modo, le antiche “leggi” di sopravvivenza dei nostri antenati Calabresi e Abruzzesi (se la terra trema, stai fuori di casa almeno tre giorni) trovarono un riscontro quantitativo: 1) i terremoti sono ravvicinati nello spazio e nel tempo (clusterizzazione), 2) un evento grande è seguito da numerosi eventi minori (repliche) che decadono rapidamente nel tempo (la legge di Omori), 3) per un dato evento di magnitudo X, esistono circa 10 eventi di magnitudo X-1 (le legge di Gutenberg-Richter), 4) il numero di repliche aumenta esponenzialmente con la magnitudo dell’evento principale (la legge di Utsu), 5) in alcuni casi, eventi grandi sono preceduti da eventi minori. Queste osservazioni sperimentali suggeriscono che i terremoti “parlano” tra di loro, anche se il linguaggio è ancora da scoprire. Infatti, la sismologia studia un terremoto come il nostro udito studia il motore di un’auto: ascoltando il rombo del motore, siamo in grado di stabilire approssimativamente la cilindrata del motore (la magnitudo) e di localizzare l’auto (l’ipocentro), ma non possiamo “vedere”come funziona il motore (la faglia). Benché siano stati compiuti sforzi significativi negli ultimi 40 anni (esperimenti di laboratorio che riproducono le condizioni che portano alla enucleazione e alla propagazione di rotture sismiche, studi di terreno di faglie oggi esposte in superficie ma un tempo attive a km di profondità che consentono di quantificare la struttura del motore dei terremoti), le conoscenze sulla fisica dei terremoti sono ancora limitate. Il modello dominante di enucleazione di un terremoto rimane quello del rimbalzo elastico proposto da Harry Reid dopo il terremoto di San Francisco del 1906. Nella versione moderna del modello, il moto relativo delle placche terrestri carica progressivamente le rocce della crosta come delle gigantesche molle. Quando le rocce non sono più in grado di sostenere queste spinte, esse si rompono lungo delle superfici chiamate faglie e l’energia elastica caricata dalle rocce nell’arco di centinaia di anni viene rilasciata in pochi secondi attraverso l’emissione di onde elastiche: il terremoto. Le onde sono emesse sia durante la propagazione della rottura, che avviene a chilometri al secondo, che durante lo sfregamento delle masse roccia, che avviene a velocità di qualche metro al secondo. Come ordine di grandezza, la faglia responsabile del terremoto dell’Aquila del 6 Aprile 2009 (M 6.3), è lunga circa 20-25 km e ha un’area di circa 240 km2; la faglia del terremoto di Sumatra del 26 Dicembre 2004 (M 9.4), è lunga circa 800 km e copre un’area di quasi 200.000 km2. Poiché passando da un grado a quello successivo nelle scale di magnitudo l’energia liberata in onde sismiche aumenta di circa 30 volte, il terremoto di Sumatra è stato 27.000 volte più energetico di quello dell’Aquila. Rimangono però molte domande che il modello del rimbalzo elastico non soddisfa: perché, per esempio, se gli esperimenti di laboratorio mostrano che il meccanismo di enucleazione di un terremoto è circa lo stesso, alcune rotture si propagano per poche decine o centinaia di metri (M 1) mentre altre diventano dei grandi terremoti distruttivi (M 9)? Occorre rispondere a questo genere di domande per prevedere un terremoto catastrofico.

Cosa vuol dire “prevedere” un terremoto?

Intanto, occorre distinguere tra previsione deterministica del luogo (coordinate geografiche), data (ora, giorno, anno) e dimensione (magnitudo) del terremoto dalla previsione probabilistica (con probabilità compresa tra 0 e 1, dove 0 è un evento impossibile e 1 un evento certo), o quante probabilità vi sono che un evento di una certa magnitudo colpirà una data area in un dato giorno. La differenza tra previsione deterministica e probabilistica distingue un ciarlatano da uno scienziato. Tutte le previsioni scientifiche sono di tipo probabilistico. Nel caso delle previsioni meteo a 24 ore l’attendibilità (“piove-non piove”) sfiora 0.9. Ma il “tempo” è un fenomeno i cui parametri principali (umidità, temperatura, ecc.) sono monitorati in tempo reale e su scala globale e quindi inseriti in una “scatola nera” (modelli matematici che simulano il comportamento dell’atmosfera tenendo conto delle leggi dei fluidi, ecc.) che produce una previsione. La previsione può essere verificata il giorno successivo: se non è corretta, si può agire sulla scatola nera. I terremoti distruttivi per l’uomo nascono a una decina di kilometri di profondità, dove non è consentito misurare i parametri fisici (temperatura, energia di deformazione elastica accumulata e proprietà frizionali delle rocce, ecc.) che controllano l’enucleazione di un terremoto; inoltre, i terremoti grandi rompono faglie di centinaia di km2 ma “nascono” da aree di faglia poco più grandi della vostra scrivania. Che dati inserire nella scatola nera che produce le previsioni di un terremoto? E, anche se avessimo una scatola nera, i terremoti distruttivi come quello dell’Aquila 2009 si ripetono ogni 250-500 anni. Come verificare la bontà della previsione?

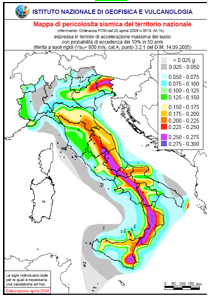

Benché le conoscenze sulla fisica dei terremoti stiano notevolmente incrementando, non abbiamo a oggi un metodo robusto per prevedere i terremoti nel breve termine e con un’elevata probabilità; non esistono segnali precursori (emissioni di Radon, sciami sismici, deformazioni del suolo, ecc.) affidabili. Per questa ragione, per l’Italia si è optato per una carta della pericolosità sismica che si basa prevalentemente sulla storia degli eventi passati: la carta indica l’accelerazione di riferimento che nel 90% dei casi non verrà superata in un periodo prefissato di 50 anni, in condizioni ottimali di risposta locale del terreno (roccia); la mappa più recente è stata pubblicata nel 2004 (fig. 1).

Fig.1 - Pericolosità sismica nazionale (INGV)

La carta è costruita impiegando il catalogo dei terremoti storici Italiani, il catalogo dei terremoti strumentali, un modello di zonazione sismotettonica che rappresenta la frequenza/magnitudo degli eventi, e le proprietà di trasmissione delle onde nelle rocce. Il catalogo dei terremoti storici Italiano, il più completo al mondo, sfrutta la lunga tradizione scritta del nostro paese ed è uno straordinario esempio delle potenzialità di simbiosi tra discipline umanistiche e scientifiche: è il risultato di un certosino studio di antichi documenti conservati in monasteri, chiese, biblioteche, ecc. dove erano registrati eventi interpretabili come causati da terremoti. Secondo la carta in Fig. 1, L’Aquila si trova nelle zone a più alta pericolosità d’Italia. Poiché i tempi di ritorno di un evento distruttivo per l’Aquila sono di ca. 250-500 anni (l’ultimo evento distruttivo era stato nel 1703) la probabilità di avere un evento distruttivo in un dato giorno, per esempio il 6 Aprile 2009, era di ca. 0.00001 = 1 / (365 giorni x 300 anni). In altre parole, la carta non prevedeva “deterministicamente” quando, ma, sempre probabilisticamente, luogo e magnitudo. La carta in Figura 1 è di riferimento per la classificazione sismica di un comune e, di conseguenza, per Legge, impone vincoli sulle caratteristiche costruttive degli edifici la cui rigorosa applicazione ridurrebbe al minimo le perdite di vite umane. In realtà, per le scarse conoscenze che abbiamo della fisica dei terremoti, per le possibili lacune nei cataloghi storici e per i lunghi tempi di ritorno dei terremoti, la carta non è necessariamente “robusta”. In altre parole, non dovrebbe stupire che in futuro in alcune aree potremmo misurare accelerazioni al suolo anche molto più elevate da quanto previsto dalla carta (come sembra essere stato il caso della sequenza Emiliana del 2012, anche tenendo conto della particolare geologia del sottosuolo dell’area che comprende uno spesso materasso alluvionale). Carte simili sono state redatte anche in altri paesi, dove hanno mostrato i loro attuali limiti. In Giappone, per esempio, il gigantesco terremoto M 9.0 del 2011 di Tohoku ha interessato un’area dove la magnitudo massima stimata era M 8.0: l’energia sismica irradiata è stata da 10 a 30 volte maggiore (e la faglia responsabile del terremoto grande circa il doppio) di quanto previsto. Questa discrepanza ha aperto un ampio dibattito nella comunità scientifica sulla validità di questi modelli a lungo termine (occorre aggiungere che, nonostante questo, i sismologi non sono stati processati in Giappone). Inoltre, questo tipo di carte non considera aspetti geologici locali di amplificazione delle onde. E, soprattutto, non considera alcuni aspetti caratteristici dei terremoti, come la loro tendenza a “clusterizzare” in brevi periodi. Quest’ultima proprietà aumenta di molto la probabilità di un evento sismico. Uno studio del 2011 (successivo al terremoto dell’Aquila) dei terremoti registrati in Italia negli ultimi sessant’anni indica che un terremoto di M > 4 ha circa l’1% di probabilità di essere seguito da un terremoto di magnitudo più grande in un raggio di 10 km dall’epicentro nelle 72 ore successive. Nel caso del terremoto M 6.3 dell’Aquila del 6 Aprile 2009 delle ore 3:32, essendo stato preceduto alle 22:48 del 5 Aprile da un evento M 4, esisteva una probabilità pari all’1% di avere un terremoto come quello che ha colpito la città poche ore dopo. In altre parole, la pericolosità calcolata sul lungo termine non è costante nel tempo: possono esserci importanti variazioni nell’arco di giorni/settimane/mesi quando vi è uno sciame sismico in atto.

I terremoti: un problema di comunicazione

Un incremento di probabilità da 0.00001 a 0.01 è un aumento significativo (tre ordini di grandezza) da un punto di vista “scientifico”, ma numeri così piccoli evidenziano la difficoltà di comunicare la pericolosità di un evento alla popolazione e ai decision makers. Che cosa significa che la probabilità di un evento aumenta da 0.00001 a 0.01? Può il sindaco ordinare l’evacuazione di una città perché vi è una probabilità su cento che nei prossimi tre giorni vi sarà un terremoto? E se il terremoto, come probabile al 99%, non arriva, quanto dovrà durare l’evacuazione? Chi coprirà i costi delle giornate lavorative perse? Chi si assumerà le responsabilità di un eventuale incidente, per esempio automobilistico, durante le fasi di evacuazione? Occorre confrontare i costi economici e sociali dell’evacuazione di una città con quello delle eventuali perdite in caso di mancata evacuazione. Questo comporta anche una valutazione del numero di potenziali vittime e del costo di una vita umana. Anche se “non ha prezzo”, le società di assicurazione attribuiscono un prezzo alle nostre vite. Se moltiplichiamo i costi delle potenziali “perdite” per la probabilità di un evento e li confrontiamo con i costi di evacuazione, è possibile prendere una decisione? E’ evidente che occorrono delle rigorose normative (preparate lontano dall’emergenza), fondate su un’analisi razionale costi/benefici, cui affidarsi per prendere decisioni che si basano su probabilità estremamente basse di realizzazione di un evento. Nei giorni del terremoto dell’Aquila, in Versilia gli alberghieri stavano procedendo con un’azione legale nei confronti dei metereologi che, avendo stilato bollettini meteo che prevedevano pioggia quando il weekend era stato soleggiato, avevano indotto numerosi turisti a cancellare le prenotazioni negli alberghi.

Il terremoto dell’Aquila del 6 Aprile è stato preceduto da una sequenza sismica di circa sei mesi, tra cui l’evento M4.1 del 30 Marzo 2009 cui fece seguito la Riunione della Commissione Grandi Rischi del 31 Marzo 2009. La riunione fu tenuta nella città dell’Aquila in un clima di tensione, sia per una popolazione sottoposta alla snervante crisi sismica, che per le voci di previsione (deterministica) di un grande terremoto ad opera di Giampaolo Giuliani. Le previsioni di Giuliani basate su misure di emissione di Radon, non hanno trovato alcun riscontro, sia pratico (le sue previsioni si sono mostrate errate sia nel tempo che nel luogo) che scientifico: nessuno dei dati raccolti da Giuliani è stato pubblicato su una rivista scientifica e i suoi dati, analizzati da una commissione di esperti internazionali, si sono mostrati non utilizzabili per prevedere un terremoto. Questo non dovrebbe sorprendere: studi rigorosi condotti negli ultimi quarant’anni hanno mostrato la non affidabilità del Radon come precursore. In quei giorni Giuliani fu denunciato per procurato allarme dalla Protezione Civile e uno degli scopi della riunione, indetta dalla Protezione Civile, era smentire le dichiarazioni di Giuliani. Alla riunione parteciparono sei scienziati: quattro sismologi, Enzo Boschi e Giulio Selvaggi (dell’Istituto Nazionale di Geofisica e Vulcanologia, l’ente preposto al monitoraggio dell’attività sismica sul territorio nazionale), Mauro Dolce (della Protezione Civile), Claudio Eva (dell’Univ. di Genova), il vulcanologo Franco Barberi (dell’Univ. di Roma Tre) e gli ingegneri Gian Michele Calvi (dell’European Centre di Ingegneria Sismica di Pavia) e Bernardo De Bernardinis (Vice Capo della Protezione Civile). La riunione durò meno di un’ora e il verbale fu firmato la mattina del 6 Aprile, quindi a terremoto avvenuto. Il 31 Marzo, prima della riunione, il vice-direttore della Protezione Civile, l’Ing. De Bernardinis, affermò in un’intervista televisiva che l’Aquila non correva pericolo alcuno perché i numerosi piccoli terremoti stavano scaricando l’energia elastica accumulata nei secoli passati: i cittadini potevano stare tranquilli e, stimolato da una frase del giornalista, disse che potevano bere un bicchiere di Montepulciano d’Abruzzo. La prima regola di comunicazione (e buon senso) è che non è possibile smentire voci scientificamente infondate (le previsioni deterministiche di Giuliani) con affermazioni altrettanto scientificamente infondate (le dichiarazioni di De Bernardinis sono inconsistenti con cento anni di studi di sismologia quantitativa i cui risultati sono il fondamento della previsione probabilistica di un terremoto). Queste affermazioni inesatte non furono contestate da specialisti (forse anche perché non ne erano a conoscenza) nei giorni che precedettero l’evento del 6 Aprile 2009 e, a detta dei parenti di 29 vittime del terremoto, hanno influenzato le loro decisioni: non abbandonare l’abitazione dopo l’evento M 4.0 delle 22:48 del 5 Aprile.

A seguito del terremoto distruttivo del 6 Aprile 2009, i sette i scienziati e tecnici che parteciparono alla riunione sono stati messi sotto processo facendo gridare la comunità scientifica ad un nuovo caso Galileo. Il 22 Ottobre 2012 sono stati condannati a sei anni di carcere per omicidio colposo. L’accusa, come affermato dal PM Fabio Picuti nell’Udienza Preliminare del Luglio 2010, non è di non aver previsto il terremoto (e di non aver richiesto di far evacuare la città), come inizialmente interpretato dalla comunità scientifica, ma di aver fornito alla popolazione informazioni lacunose e contraddittorie sulla crisi sismica e di non aver comunicato in maniera esaustiva alla popolazione come comportarsi durante la crisi. Benché la posizione di alcuni degli scienziati coinvolti sia diversa (vedi il caso di Giulio Selvaggi che non faceva parte della commissione grandi rischi e fu convocato in maniera ufficiosa per riassumere lo stato della crisi sismica) o il fatto che, secondo la Legge, è il Dipartimento della Protezione Civile che sulla base del parere degli esperti, prende delle decisioni sul tipo di azioni da portare alla popolazione, la situazione è complessa. A difesa dei sismologi possiamo affermare che il terremoto era stato previsto probabilisticamente (quindi non nel giorno, Fig. 1), che se le case dell’Aquila fossero stare sufficientemente robuste da resistere alle sollecitazioni previste in Fig. 1 forse non ci sarebbero state vittime e che, in ogni caso, è la Protezione Civile l’ente preposto all’azione nei confronti della popolazione.

La severa condanna agli imputati lascia però estremamente perplessi. Sfortunatamente, il processo, almeno sfogliando la Requisitoria del Settembre 2012, non è riuscito a fare chiarezza su molti aspetti, per esempio i rapporti tra Istituto Nazionale di Geofisica e Vulcanologia e Protezione Civile (all’epoca, l’INGV aveva almeno 450 precari il cui stipendio era pagato in parte su progetti finanziati dalla Protezione Civile), sul perché il verbale della riunione della Commissione Grandi Rischi del 31 Marzo 2009 è stato firmato dopo il terremoto del 6 Aprile 2009, sul perché il capo della Protezione Civile, Bertolaso, “spingeva”, come emerso dalle intercettazioni telefoniche, per “tranquillizzare” la popolazione e intanto le alte sfere della Protezione Civile erano concentrate sul G8 da svolgersi alla Maddalena. Molti di questi “perché” potrebbero non avere nulla a che fare con i terremoti, con il concetto di rischio e con la scienza: potrebbero invece avere a che fare più prosaicamente con questioni tipicamente “Italiane” che ricordano in parte il caso della diga e della frana del Vaiont (Ottobre1963, 2000 vittime). Inoltre, la sentenza sembra essere, ma occorre leggere ancora le motivazioni della condanna, ingiusta. Il concetto di “responsabilità collettiva” invocato dal PM Picuti nei confronti dei componenti (e anche di chi non era componente, vedi il caso di Giulio Selvaggi) della Commissione Grandi Rischi non regge ad un elementare processo logico, almeno per un comune cittadino come me. Se l’accusa è che delle persone hanno preso una decisione (restare o non restare in casa) sulla base di informazioni ricevute dai mass media, sono coloro che hanno rilasciato quelle interviste che rispondono di queste informazioni. L’affermazione poi che tutti i componenti della Commissione Grandi Rischi potevano essere al corrente di quanto affermato da uno di loro perché l’intervista era stata trasmessa su di un canale nazionale (telegiornali TG 1 e TG 5) è altrettanto illogica: nessuno (per fortuna non viviamo ancora nel paese del romanzo 1984 di Orwell) è tenuto ad ascoltare un particolare telegiornale. L’altra imputazione, come si legge nella Requisitoria del Settembre 2012, di “grave deficit comunicativo, grave deficit informativo, la grave sottovalutazione del rischio in capo agli imputati...” è molto pericolosa. Se è facile distinguere un’informazione esatta da una errata, è forse impossibile affermare quando l’informazione sarà completa, soprattutto a posteriori e quando l’informazione riguarda eventi a bassa probabilità di accadimento (specie considerato che, nei fatti, a molti degli interlocutori politici e al comune cittadino spesso sfugge il concetto di probabilità).

In ogni caso, come dichiarato dal sismologo Tom Jordan, direttore del Southern California Earthquake Center preposto al monitoraggio della Faglia di San Andreas, prima della sentenza di condanna, il processo segna uno spartiacque: il processo costringerà i sismologi di tutto il mondo a rivedere il modo con cui comunicare la probabilità di eventi disastrosi con bassissime percentuali di accadimento e come rapportarsi con i mass media.

La comunità scientifica deve avere la massima trasparenza e comunicare nella maniera più chiara possibile messaggi non contraddittori. Nei giorni precedenti e successivi al terremoto dell’Aquila, ricercatori e professionisti a volte con scarsa competenza in fatto di terremoti e impreparati a gestire le domande di un giornalista creavano ulteriore confusione. Abbiamo assistito alla Caporetto della Comunicazione Scientifica con una grave perdita di fiducia da parte del cittadino nei confronti della Scienza. Per affrontare situazioni di questo tipo che inevitabilmente si ripeteranno (vedi il caso del Vesuvio) è indispensabile una regia e un soggetto di riferimento attualmente assenti nella comunità scientifica Italiana (e forse globale). Ma è altrettanto vero che il problema di comunicazione è biunivoco. Diversi giornali (La Repubblica) e uomini politici (Antonio Di Pietro) nei giorni successivi al terremoto proclamavano Giampaolo Giuliani l’eroe inascoltato che aveva previsto il terremoto. E’ necessario che gli interlocutori (politici, giornalisti, e, di seguito, la popolazione) sappiano selezionare le fonti, conoscano i rudimenti del metodo scientifico, e, in futuro, decision-makers e cittadini siano in grado di prendere decisioni sulla base di previsioni con bassissima probabilità di accadimento. L’alluvione del Novembre 2011 di Genova insegna che in Italia (e non solo, basti pensare alla gestione dell’uragano Katrina che infierì lungo la costa meridionale degli USA nel 2005), anche nel caso di previsioni a elevata probabilità di accadimento, i decision makers sono impreparati nel gestire queste informazioni.

Fortunatamente i terremoti hanno tempi di ritorno lunghi nel nostro paese, da 250 a 1000 e più anni, ma questo si ritorce contro perché dimentichiamo in fretta. E’ compito dei mass media, debitamente informati, ricordare che il nostro è un paese sismico (la carta in Fig. 1 è accessibile a tutti). L’INGV e molte scuole pubbliche organizzano regolarmente corsi su come occorra agire prima (per esempio, fissare i mobili alle pareti) e durante un terremoto (rifugiarsi sotto le travi portanti o un tavolo), semplici regole di comportamento che possono salvare vite umane.

Nei giorni antecedenti al terremoto dell’Aquila, il governo Berlusconi proponeva il piano di ampliamento del 25% delle abitazioni come stimolo alla stagnante economia. Non ci fu un solo parlamentare della maggioranza che avesse ricordato che sarebbe stato più saggio spendere quei soldi per rinforzare le nostre scuole e abitazioni. Esiste un’emergenza di comunicazione che è il lontano riflesso di una più accecante emergenza culturale.

Fonte: Il Bo

Bibliografia:

D’Avolio, R., Picuti, F., 2012. Proc. Pen. 253/10: Requisitoria (del Processo dell’Aquila), 25 Settembre 2012, 511 pagine.

Hall, S.S. 2011. At Fault? Nature 477, 264-269.

Hough, S., 2010. Predicting the unpredictable. Princeton University Press, Princeton, USA.

Jordan, T.H., Chen, Y-T., Gasparini, P., Madariaga, R., Main, I., Marzocchi, W., Papadopoulos, G., Sobolev, G.,

Yamaoka, K., Zschau, J., 2011. Operational earthquake forecasting. Annals of Geophysics 54, 315-391.

Picuti, F., 2010. Proc. Pen. 253/10. Memoria del P.M. al Giudice per l’Udienza Preliminare, 13 Luglio 2010, 224 pagine.