Quanto vale una ricerca e quanto dobbiamo finanziarla? Basta un semplice calcolo delle citazioni ottenute? Oppure la questione è un po' più complessa? (Crediti: Jedediah Laub-Klein, via Flickr)

Sono tempi in cui chi investe, pubblico o privato, si preoccupa di ridurre al minimo gli sprechi, massimizzare l’efficenza, aumentare la resa. Anche nell’ambito della ricerca scientifica, da sempre materia complessa da valutare perché opera collettiva, in cui i contribuiti dei singoli ricercatori affluiscono nei gruppi di ricerca e sono poi rielaborati da altri gruppi, magari molti anni dopo. Higgs ha vinto il Nobel a distanza di 50 anni con una manciata di pubblicazioni.

Gli apparati amministrativi, alla ricerca di metodi semplici per domare questa creatura esotica, hanno presto ceduto alle promesse della bibliometria: valutare un ricercatore attraverso un semplice numero fornito dal calcolo (basato su algoritmi più o meno sofisticati) delle citazioni ottenute dalle sue pubblicazioni.

Valutare la ricerca, con criterio

Quanto vale quella ricerca e quanto dobbiamo finanziarla? Calculemus. Troppo facile. Un po’ come giudicare la pulizia dal profumo di pulito. Infatti da sempre la comunità scientifica ha individuato gli effetti collaterali causati da un uso brutale dei criteri bibliometrici: una crescita artificiale del numero di pubblicazioni (Publish or perish...), strategie citazionali più o meno lecite per incrementare il proprio ranking, eccetera. Nonostante questi avvertimenti l'Italia, a partire dalla riforma universitaria del 2010, ha esteso il peso di questi criteri attraverso la creazione dell'ANVUR, l'Agenzia nazionale di valutazione del sistema universitario e della ricerca. Agli occhi di alcuni un Moloch che decide in modo acefalo chi è meritevole e chi no di spartirsi le (scarse) risorse a disposizione.

Autocitazioni: due ricerche

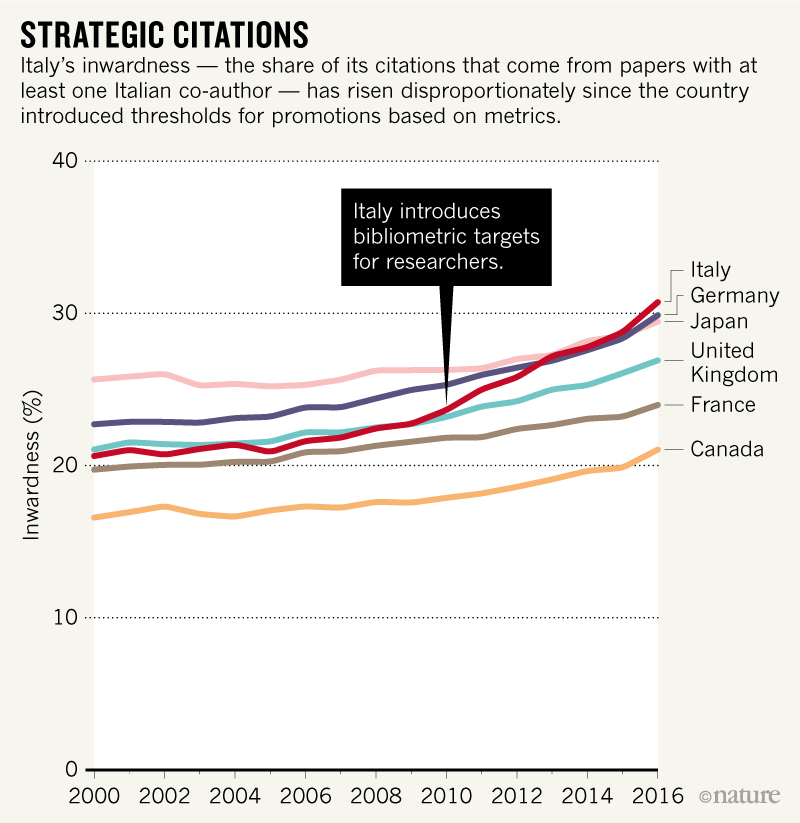

Due articoli pubblicati recentemente su riviste scientifiche hanno riacceso il dibattito nostrano portando nuovi elementi di discussione. Alberto Baccini, Giuseppe De Nicolao ed Eugenio Petrovich hanno mostrato che l'introduzione di criteri strettamente bibliografici per valutare la ricerca induce la comunità scientifica a costituire in modo spontaneo club più o meno numerosi propensi a citarsi vicendevolmente. La metrica che misura questa attitudine è chiamata “Inwardness”. Viste le scarsissime risorse in gioco possiamo anche chiamarla “istinto di sopravvivenza”. Questo ha determinato maggiori punteggi negli indici bibliometrici che hanno fatto compiere all’Italia un balzo in avanti nelle classifiche internazionali. (Baccini et al. Citation gaming induced by bibliometric evaluation: A country-level comparative analysis. PLOS One, September 11, 2019)

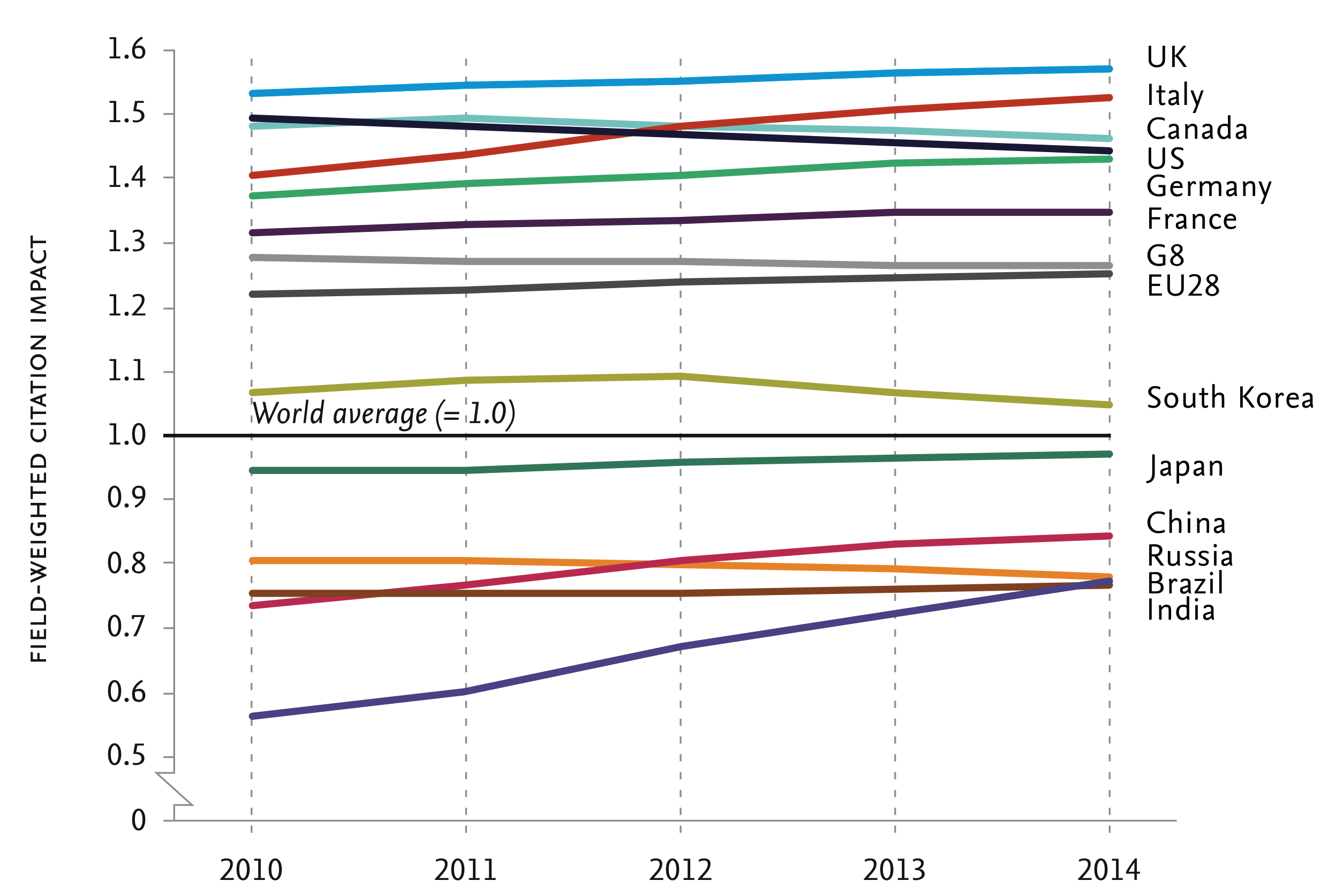

Citation impact pesato per campo di ricerca ( periodo: 2010-2014).

La ricerca italiana non è diventata di colpo più efficiente (come avrebbe voluto la riforma Gelmini che ha ispirato i nuovi criteri di valutazione), né i ricercatori italiani sono degli astuti vanesi, come ipotizza sul Corriere della Sera Gian Antonio Stella che ha un po’ semplificato la lettura dello studio (I professori si citano da soli. Così si gonfia la ricerca). Molti di loro hanno speso ore di vita e risorse per produrre una buona ricerca: saputo che sarebbero stati valutati in modo deterministico attraverso un singolo parametro bibliometrico, hanno adottato una mera strategia di sopravvivenza. È bene ricordare che anche negli altri paesi, e per ragioni analoghe, si ha una Inwardness elevata.

Figura tratta dal commento pubblicato su Nature (Italy’s rise in research impact pinned on ‘citation doping’, 13 settembre 2019) dell’articolo di Baccini et al.

L’ipotesi di un aumento della inwardness a seguito dell’introduzione di stringenti criteri bibliometrici nella valutazione della ricerca era stata formulata da tempo: Baccini e colleghi hanno potuto osservare in diretta il fenomeno atteso, come capita ai fortunati astronomi in caccia di supernovae. La scoperta è stata quindi messa al vaglio dagli esperti: alcuni hanno riprodotto i risultati della ricerca e sono giunti alle stesse conclusioni; altri si sono mostrati più cauti, come il biostatistico e condirettore del Meta-Research Innovation Center dell’Università di Stanford John Ioannidis che si spinge ad affermare che l’effetto inwardness può essere dovuto a un numero molto limitato di ricercatori che si citano a vicenda e comunque non si può escludere che il risultato sia dovuto al caso più che alle regole introdotte dall’ANVUR.

Ioannidis stesso sembra proporre, con una sua pubblicazione di qualche giorno prima (Ioannidis et al. A standardized citation metrics author database annotated for scientific field. PLOS Biology, 12 agosto 2019), una lente correttiva che risolve la distorsione creata dall'effetto inwardness: nuovi algoritmi in grado di individuare gruppi che si autocitano e ridefinire le classifiche. Ioannidis, analizzando in questo modo milioni di citazioni per migliaia di ricercatori, ha mostrato che le posizioni, anche al vertice, possono variare descrivendo una situazione più aderente alla realtà.

Come cambia la classifica dei primi 10 ricercatori con o senza autocitazioni secondo Ioannidis.

Anche questo lavoro però ha subito critiche nel merito, le autocitazioni, di un singolo o tra gruppi, non sono un male in sé: se un ricercatore indaga un argomento negli anni o si autocita o si autoplagia. Inoltre tutti i dataset che contengono milioni di citazioni possono soffrire di alcuni difetti (tipico l’errore nell’attribuire una affiliazione) che se non impediscono una analisi dei grandi numeri possono inficiare l'estensione di classifiche individuali. Errori che possono rivelarsi esiziali quando queste stesse classifiche diventano il parametro principale per valutare e finanziare la ricerca. Senza contare che le correzioni proposte da Ioannidis sarebbero in breve aggirate dagli adattamenti dei ricercatori.

Perché la bibliometria importa

È vero però che analizzando gli elenchi per singoli settori e riordinando i presenti per citazioni secche, si trova che nelle prime posizioni ci sono quelli che uno si aspetterebbe. Quindi l'analisi bibliometrica sembra in grado di restituire l'eccellenza e far emergere personalità indipendenti: i citation ring probabilmente non possono influenzare i livelli alti della classifica (come gli Highly Cited Researchers) mentre sono effettivamente in grado di influenzare la classifica nelle posizioni medio/basse, in lotta per un buon piazzamento nella valutazione dall’ANVUR.

La situazione è compelssa e calcolare non basta. La ricerca è un'opera collettiva il cui valore difficilmente può essere fotografato da una semplice formula. Come ricorda Alberto Mantovani, tra i ricercatori di punta del nostro paese, sul Corriere della Sera, «in generale i ranking sono sempre perfettibili, ma soprattutto i parametri bibliometrici su cui si basano devono essere considerati per quello che sono: uno strumento di giudizio. Che come tale non può sostituirsi alla valutazione».